- Google の PaLM 2 大規模言語モデルは、CNBC が学習した前身の LLM の 5 倍近くのテキスト データをトレーニングに使用します。

- Googleは先週PaLM 2を発表した際、このモデルは以前のPaLMより小型だが、より効率的な「テクノロジー」を使用していると述べた。

- AI モデルのトレーニング データに関する透明性の欠如が、研究者の間でますます話題になっています。

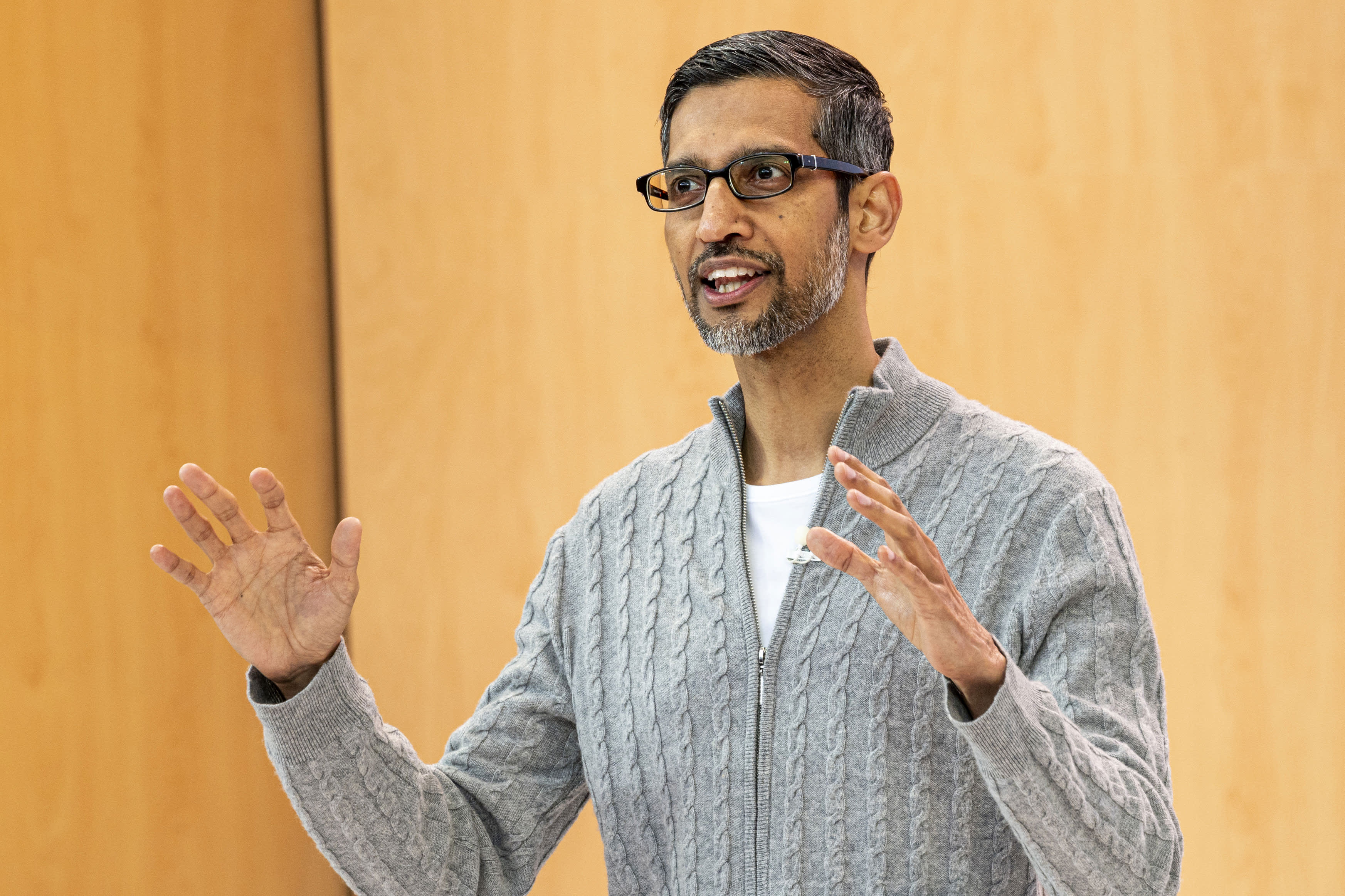

サンダー・ピチャイ氏、アルファベット社CEO 、2023年5月10日水曜日にカリフォルニア州マウンテンビューで開催されたGoogle I/O開発者カンファレンス中に。

デビッド・ポール・モリス | ブルームバーグ | ゲッティイメージズ

CNBC は、同社が先週発表した Google の新しいビッグ言語モデルでは、2022 年から以前のモデルに比べて 5 倍近くのトレーニング データが使用され、より高度なコーディング、数学、クリエイティブ ライティングのタスクを実行できるようになることを知りました。

CNBCが確認した内部文書によると、Google I/Oで発表された同社の新しい公共利用大規模言語(LLM)モデルであるPaLM 2は、3兆6000億トークンでトレーニングされたという。 単語の文字列であるトークンは、シーケンス内に表示される次の単語を予測するようにモデルに教えるため、LLM をトレーニングするための重要な構成要素です。

Google の以前のバージョンの PaLM (Pathways Language Model の略) は 2022 年にリリースされ、7,800 億のトークンでトレーニングされました。

Google は、自社の AI テクノロジーの能力と、それを検索、電子メール、ワードプロセッサ、スプレッドシートにどのように統合できるかを示すことに熱心でしたが、トレーニング データの量やその他の詳細を公開することに消極的でした。 Microsoft が支援する ChatGPT のイノベーターである OpenAI も、GPT-4 と呼ばれる最新の LLM 言語の詳細を秘密にしています。

両社は、開示不足の理由は事業の競争力にあると主張している。 GoogleとOpenAIは、従来の検索エンジンの代わりにチャットボットを使用して情報を検索したいと考えているユーザーの獲得を急いでいる。

しかし、AIの軍拡競争が激化するにつれ、研究コミュニティは透明性の向上を求めている。

PaLM 2を発表して以来、Googleは新しいモデルが以前のLLMよりも小さいと述べてきたが、これは同社のテクノロジーがより複雑なタスクを実行しながらより効率的になることを意味するため、これは重要なことである。 内部文書によると、PaLM 2 は 3,400 億個のパラメーターでトレーニングされており、これはモデルの複雑さを示しています。 初期の PaLM は 5,400 億のパラメーターでトレーニングされます。

Googleはこの件についてすぐにはコメントを出していない。

グーグル 彼は言った PaLM 2 に関するブログ投稿では、このモデルでは計算スケール最適化と呼ばれる「新しい技術」が使用されています。 これにより、LLM は「推論の高速化、サービス パラメーターの減少、サービス コストの削減など、全体的なパフォーマンスが向上し、より効率的になります」。

PaLM 2の発表において、Googleはモデルが100の言語でトレーニングされ、幅広いタスクを実行するという以前のCNBCの報道を認めた。 これはすでに、同社の実験的なチャットボット Bard を含む 25 の機能と製品を強化するために使用されています。 最小から最大まで、ヤモリ、カワウソ、バイソン、ユニコーンの 4 つのサイズがあります。

公開情報に基づくと、PaLM 2 は既存のどのモデルよりも強力です。 Facebook の LLM は LLaMA と呼ばれます。 発表 2月には1兆4000億トークンを使ってトレーニングされた。 OpenAI が最後に ChatGPT トレーニング ボリュームを共有したのは GPT-3 のときで、そのとき同社は、その期間に 3,000 億のコードをトレーニングしたと発表しました。 OpenAIは3月にGPT-4をリリースし、いくつかの専門的なテストで「人間レベルのパフォーマンス」を示したと述べた。

Google による LaMDA と LLM の会話 フット CNBCが確認した最新の文書によると、2年前にBardと並んで2月に昇格し、1兆5000億トークンを使ってトレーニングされてきたという。

新しい AI アプリケーションがすぐに主流になるにつれて、基盤となるテクノロジーに関する議論も同様に行われます。

メディ・エルモハマディ氏、Google 上級研究員、 彼は2月に辞任した 会社の透明性の欠如について。 OpenAIの最高経営責任者(CEO)サム・アルトマン氏は火曜日、プライバシーとテクノロジーに関する上院司法小委員会の公聴会で証言し、AIに対処するには新たなシステムが必要であると議員らと同意した。

「非常に新しいテクノロジーには、新しいフレームワークが必要です」とアルトマン氏は言う。 「確かに、私たちのような企業は、私たちが世に出すツールに対して大きな責任を負っています。」

— CNBCのジョーダン・ノヴェッテ氏がこのレポートに寄稿しました。

彼は見てる: OpenAI CEOのサム・アルトマン氏はAIの管理を呼びかけた

“Analyst. Television trailblazer. Bacon fanatic. Internet fanatic. Lifetime beer expert. Web enthusiast. Twitter fanatic.”

/cdn.vox-cdn.com/uploads/chorus_asset/file/25592468/2113290621.jpg)

More Stories

悪魔城ドラキュラ ドミナス コレクションの物理的なリリースが決定、予約注文は来月開始

Microsoftは最新のWindows 11アップデートでRyzen CPUのパフォーマンスを向上させています

バービー人形がスマートフォン依存症を克服できると企業が主張